La mayoría tendemos a tirar de costumbre: abres Azure, necesitas un modelo de lenguaje, y casi sin pensarlo acabas usando ChatGPT. Es cómodo, es conocido y funciona bastante bien para casi todo. Pero lo cierto es que hay un montón de modelos disponibles que quizá sean mejores en tareas concretas, y ahora Microsoft ha dado un paso para que sea un poco más fácil comparar y decidir.

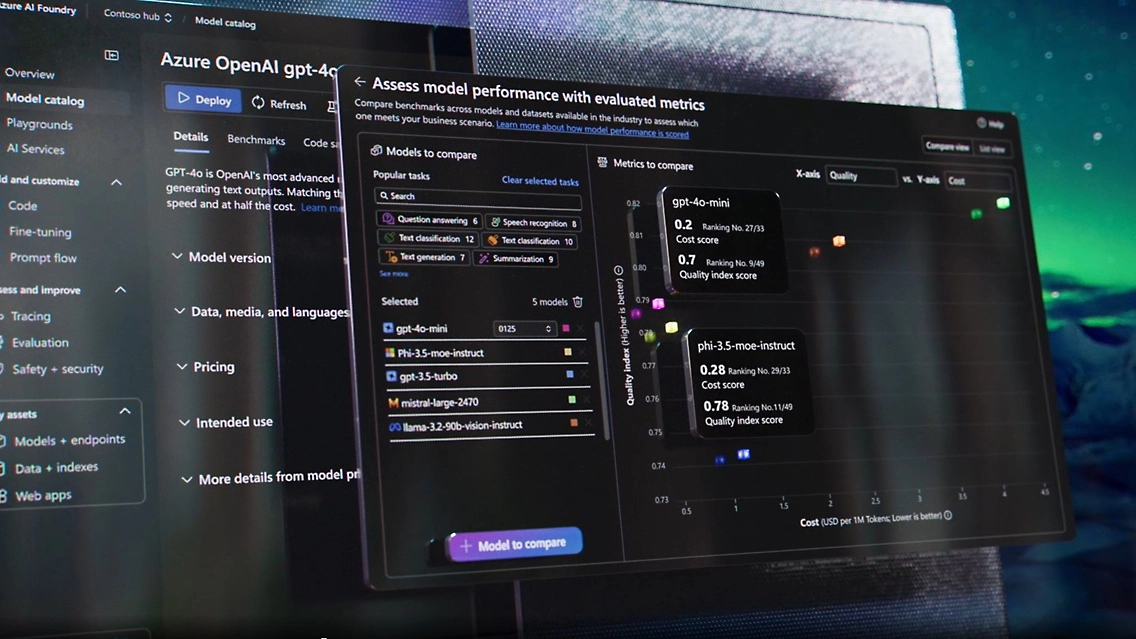

Desde hace unos días, Azure Foundry muestra una nueva métrica de seguridad junto al resto de indicadores de rendimiento, como la precisión o el coste. La idea es bastante sencilla: no todos los modelos generan contenidos igual de seguros, y algunos pueden producir más lenguaje tóxico, sesgado o problemático que otros. Para medirlo, Microsoft ha incorporado benchmarks como ToxiGen, que detecta toxicidad en las respuestas, y WMD Proxy, que evalúa si el modelo se desvía hacia contenidos delicados comparando distancias semánticas con ejemplos de referencia.

En la práctica, esto significa que cuando vayas a elegir un modelo en Azure Foundry, verás una especie de ranking de seguridad, que puede ayudarte a decidir si te conviene usar un modelo ultra creativo pero más “arriesgado”, o uno más conservador en entornos donde no te puedes permitir un desliz.

Lo interesante es que este nuevo enfoque invita a salir un poco del piloto automático. Muchos entornos corporativos tienden a quedarse siempre con el mismo modelo —ChatGPT en su versión más reciente— simplemente por comodidad o porque viene preintegrado en Copilot. Pero si tu proyecto necesita, por ejemplo, generar resúmenes neutrales o clasificar grandes volúmenes de información sensible, puede que otro modelo (de Meta, Cohere, Mistral o incluso de código abierto) sea más adecuado y seguro.

Esto no significa que el ranking sea una varita mágica que resuelva todos los problemas de la IA generativa, pero sí es un avance interesante hacia una evaluación más transparente. Al final, no todos los proyectos tienen los mismos riesgos ni las mismas prioridades, y disponer de datos claros sobre seguridad es un paso que muchos agradecíamos.

Si tienes curiosidad, puedes echar un vistazo a la documentación oficial de Azure AI o explorar el catálogo de modelos en Azure Foundry. Quién sabe, igual descubres que hay vida más allá de ChatGPT y que no todo pasa por usar siempre el modelo más famoso.

esto es una prueba