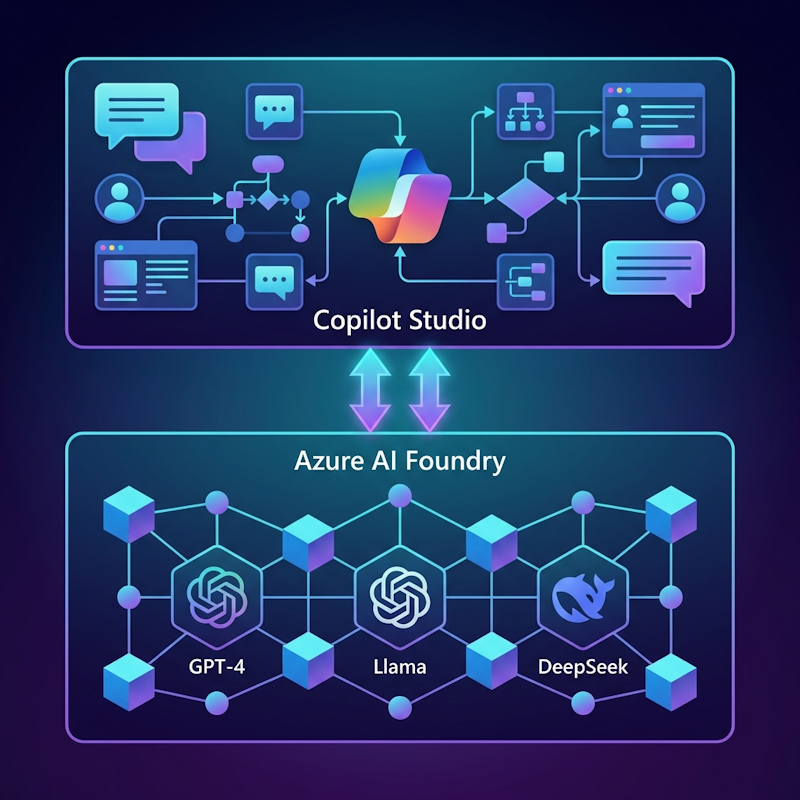

La convergencia de dos mundos: low-code y modelos avanzados

Hasta hace poco, si querías construir un agente conversacional con Copilot Studio, estabas limitado a los modelos que Microsoft ofrecía de serie. Funcionaban bien para casos generales, pero cuando necesitabas algo más especializado —un modelo fine-tuneado para tu industria, capacidades de razonamiento avanzado, o simplemente más potencia bruta— tenías que saltar a otro ecosistema y perder las ventajas del desarrollo low-code.

Eso ha cambiado. Microsoft ha abierto la puerta para conectar Copilot Studio directamente con Azure AI Foundry, permitiendo lo que llaman "Bring Your Own Model" (BYOM). En la práctica, esto significa que puedes usar cualquiera de los más de 11,000 modelos del catálogo de Azure AI Foundry (incluyendo GPT-4o, Llama 3, DeepSeek R1, y modelos propios fine-tuneados) dentro de tus agentes de Copilot Studio.

El resultado es lo mejor de ambos mundos: arquitecturas híbridas donde Copilot Studio maneja la orquestación conversacional, la lógica de negocio y la experiencia de usuario con herramientas low-code, mientras Azure AI Foundry proporciona la potencia de inferencia para las tareas que realmente la necesitan.

¿Qué es Azure AI Foundry y por qué importa?

Azure AI Foundry (el nombre actual de lo que antes conocíamos como Azure AI Studio) es la plataforma unificada de Microsoft para construir, desplegar y gestionar aplicaciones de IA a escala empresarial. No es solo un catálogo de modelos: es un ecosistema completo que incluye:

- Catálogo de modelos masivo: Más de 11,000 modelos de OpenAI, Meta, Microsoft, Mistral, Cohere, y la comunidad open source. Desde los últimos GPT-4 hasta modelos especializados en código, matemáticas o idiomas específicos.

- Despliegue serverless: Endpoints que escalan automáticamente según demanda. Pagas por tokens consumidos, no por infraestructura ociosa.

- Fine-tuning integrado: Herramientas para adaptar cualquier modelo base a tus datos específicos, sin necesidad de infraestructura propia de entrenamiento.

- Distillation: Flujos para crear modelos más pequeños y eficientes a partir de modelos grandes, optimizando coste y latencia.

- Playground de experimentación: Entorno visual para probar prompts y configuraciones antes de integrar en producción.

- Gobernanza empresarial: Control de acceso con Entra ID, monitorización de uso, auditoría de llamadas y cumplimiento normativo.

La idea central es que Azure AI Foundry actúa como el "backend pesado" de IA para toda la organización, mientras que herramientas como Copilot Studio, Power Apps o aplicaciones custom consumen esos modelos según sus necesidades.

Dos formas de integrar: modelos y agentes

Hay dos métodos principales para conectar Copilot Studio con Azure AI Foundry, y cada uno resuelve un problema diferente:

Método 1: Usar un modelo de Foundry para respuestas generativas

Este método te permite reemplazar o complementar el modelo de respuesta predeterminado de Copilot Studio con uno desplegado en Azure AI Foundry. En esencia, le dices a Copilot Studio: "cuando necesites generar una respuesta, usa este modelo en lugar del predeterminado".

Casos de uso ideales:

- Necesitas un modelo más potente para respuestas complejas (GPT-4 Turbo, DeepSeek R1)

- Has fine-tuneado un modelo con datos de tu industria o empresa

- Quieres usar modelos open source como Llama 3 para reducir costes o evitar dependencia de un proveedor

- Tu caso de uso requiere capacidades multimodales (análisis de imágenes con GPT-4o)

Método 2: Conectar un agente de Foundry como agente externo

Este método es diferente: en lugar de usar solo un modelo, conectas un agente completo construido en Azure AI Foundry. Ese agente puede tener su propia lógica, herramientas (code interpreter, file search, funciones custom) y flujos de trabajo.

Casos de uso ideales:

- Tienes flujos complejos que requieren orquestación multi-paso que va más allá de lo que Copilot Studio ofrece

- Necesitas herramientas específicas de Foundry como ejecución de código Python en tiempo real

- Quieres que equipos diferentes desarrollen agentes especializados de forma independiente

- Estás migrando gradualmente agentes de Azure a Copilot Studio y quieres reutilizar lo existente

Configuración paso a paso: Conectar un modelo de Azure AI Foundry

Vamos con el proceso completo para el Método 1. Es más sencillo de lo que parece.

Requisitos previos

Antes de empezar, asegúrate de tener:

- Una suscripción de Azure con acceso a Azure AI Foundry

- Un proyecto creado en Azure AI Foundry

- Un agente en Copilot Studio donde quieras usar el modelo

- Permisos de administrador en ambas plataformas (o al menos permisos para crear despliegues y modificar agentes)

Paso 1: Desplegar el modelo en Azure AI Foundry

Primero necesitas tener el modelo corriendo como un endpoint accesible.

- Accede a Azure AI Foundry e inicia sesión con tu cuenta de Azure.

- Abre tu proyecto existente o crea uno nuevo si es necesario.

- En el menú lateral, ve al Model Catalog.

- Usa el buscador para encontrar el modelo que quieres. Por ejemplo:

gpt-4opara el modelo multimodal más reciente de OpenAILlama-3.3-70B-Instructpara el modelo grande de MetaDeepSeek-R1para razonamiento matemático avanzado

- Haz clic en el modelo y selecciona Deploy → Serverless API.

- Dale un nombre al despliegue (algo descriptivo como

gpt4o-copilot-prod) y confirma. - Espera unos segundos mientras Azure provisiona el endpoint.

- Una vez desplegado, ve a Models + Endpoints en el menú lateral.

- Haz clic en tu despliegue y copia estos tres valores (los necesitarás después):

- Target URI: La URL del endpoint (algo como

https://xxx.openai.azure.com/...) - Deployment name: El nombre que le diste al despliegue

- API Key: La clave de autenticación (haz clic en "Show" para verla)

- Target URI: La URL del endpoint (algo como

Paso 2: Conectar el modelo en Copilot Studio

Ahora viene la parte de Copilot Studio. Tienes dos opciones según cómo quieras usar el modelo:

Opción A: Como modelo de respuesta primario (reemplaza el predeterminado)

Esta opción hace que todas las respuestas generativas de tu agente usen el modelo de Foundry.

- Abre tu agente en Copilot Studio.

- Ve a Settings (icono de engranaje) → Generative AI.

- En la sección "Primary response model", haz clic en el desplegable.

- Selecciona Connect a model bajo la sección "From Azure AI Foundry (preview)".

- Aparecerá un formulario. Introduce:

- Target URI: Pega la URL del endpoint

- Deployment name: El nombre del despliegue

- API Key: La clave de autenticación

- Haz clic en Connect.

- Copilot Studio verificará la conexión. Si todo está bien, verás una confirmación.

Desde este momento, cualquier respuesta generativa de tu agente usará ese modelo.

Opción B: Usando el Prompt Tool (para tareas específicas)

Esta opción es más granular: creas una "herramienta" que llama al modelo de Foundry, y la usas solo cuando la necesitas dentro de un topic específico.

- En tu agente, ve a la sección Tools en el menú lateral.

- Haz clic en Add Tool → Prompt.

- Dale un nombre descriptivo a la herramienta (ej: "Análisis de sentimiento con GPT-4").

- En la configuración del prompt, haz clic en el selector de modelo (esquina superior derecha del editor).

- Elige Azure AI Foundry Models en lugar del modelo predeterminado.

- Introduce los datos de conexión (endpoint, deployment name, API key).

- Escribe el prompt del sistema y define las variables de entrada y salida.

- Guarda la herramienta.

Ahora puedes invocar esta herramienta desde cualquier topic usando el nodo de "Call an action".

Configuración paso a paso: Conectar un agente de Azure AI Foundry

El Método 2 es diferente: aquí no conectas un modelo, sino un agente completo que has construido en Foundry.

Paso 1: Obtener información del agente en Foundry

- Abre tu proyecto en Azure AI Foundry.

- En la página principal del proyecto, busca el campo Project endpoint y copia la URL completa (algo como

https://tu-proyecto.api.azureml.ms). - Ve a la sección Agents en el menú lateral.

- Localiza el agente que quieres conectar y copia su Agent ID (normalmente es el nombre del agente o un identificador único).

Paso 2: Añadir el agente en Copilot Studio

- Abre tu agente en Copilot Studio.

- Ve a la pestaña Agents en el menú lateral (o haz clic en "Add agent" desde la página Overview).

- Haz clic en Add → Connect to an external agent.

- En la lista de opciones, selecciona Microsoft Foundry.

- Se abrirá el formulario de conexión. Haz clic en Create new connection.

- Pega el Azure AI Project Endpoint que copiaste antes.

- Haz clic en Create y autentícate con tus credenciales de Microsoft.

- Una vez conectado, haz clic en Next.

- Introduce el Agent ID del agente de Foundry.

- Dale un nombre al agente (cómo aparecerá en Copilot Studio).

- Escribe una descripción detallada de lo que hace el agente. Esta descripción es importante: Copilot Studio la usa para decidir cuándo invocar al agente automáticamente.

- Haz clic en Save.

El agente de Foundry aparecerá ahora en tu lista de agentes colaboradores. Puedes referenciarlo explícitamente desde tus topics, o dejar que Copilot Studio lo invoque automáticamente cuando detecte que la consulta del usuario encaja con la descripción del agente.

Arquitecturas híbridas: patrones de diseño recomendados

La integración abre un abanico de arquitecturas posibles. Estos son los patrones más comunes:

Patrón 1: Copilot Studio como orquestador, Foundry como motor de inferencia

Toda la lógica conversacional, validaciones, integraciones con Dataverse/SharePoint, y flujos de negocio viven en Copilot Studio. Cuando se necesita procesamiento pesado —análisis de documentos extensos, razonamiento complejo, generación de código, o análisis de imágenes— se llama al modelo de Foundry.

Usuario → Copilot Studio (orquestación) → Azure AI Foundry (inferencia) → respuestaVentajas:

- Desarrollo rápido con herramientas low-code

- Fácil de mantener por equipos no técnicos

- Costes controlados (solo pagas inferencia cuando la necesitas)

- Integración nativa con el ecosistema Microsoft/Power Platform

Patrón 2: Multi-agente con especialización por dominio

Varios agentes de Foundry especializados —uno para finanzas, otro para soporte técnico, otro para recursos humanos— conectados a un agente principal de Copilot Studio que actúa como "router" y enruta las consultas al agente adecuado.

Usuario → Copilot Studio (router)

├→ Agente Foundry: Finanzas

├→ Agente Foundry: Soporte

└→ Agente Foundry: RRHHVentajas:

- Escalabilidad: cada agente puede evolucionar independientemente

- Equipos independientes: el equipo de finanzas mantiene su agente, el de soporte el suyo

- Modelos optimizados: puedes usar un modelo fine-tuneado diferente para cada dominio

- Costes granulares: sabes exactamente cuánto consume cada área

Patrón 3: Arquitectura híbrida con Azure Arc (on-premises)

Para organizaciones con requisitos estrictos de residencia de datos, latencia o cumplimiento normativo, Azure AI Foundry puede desplegar modelos on-premises o en el edge usando Azure Arc. Copilot Studio sigue siendo el frontend en la nube, pero la inferencia ocurre dentro de la infraestructura privada de la organización.

Usuario → Copilot Studio (nube) → Azure Arc → Modelo (on-premises) → respuestaVentajas:

- Cumplimiento normativo: los datos nunca salen de tu infraestructura

- Datos sensibles: ideal para sanidad, finanzas, gobierno

- Baja latencia: el modelo está cerca de los datos

- Control total: tú gestionas la infraestructura de inferencia

Patrón 4: Escalado progresivo de complejidad

Empiezas con el modelo predeterminado de Copilot Studio para la mayoría de interacciones (coste cero adicional). Para consultas que el modelo base no puede resolver bien, escalas a un modelo más potente de Foundry (GPT-4o). Y para tareas muy especializadas, invocas un agente de Foundry con herramientas específicas.

Consulta simple → Modelo base Copilot Studio

Consulta media → GPT-4o via Foundry

Consulta compleja → Agente Foundry especializadoVentajas:

- Optimización de costes: usas recursos caros solo cuando es necesario

- Mejor experiencia: cada tipo de consulta recibe el tratamiento adecuado

- Evolución gradual: puedes empezar simple e ir añadiendo complejidad

Catálogo de modelos: qué puedes usar y para qué

El catálogo de Azure AI Foundry incluye modelos para casi cualquier caso de uso. Estos son los más relevantes para agentes conversacionales:

Modelos de OpenAI

- GPT-4o: El modelo estrella actual. Multimodal (texto, imagen, audio), rápido, y con muy buena relación calidad/precio. Ideal como modelo de respuesta primario para agentes versátiles.

- GPT-4 Turbo: Contexto extendido de 128K tokens. Perfecto para procesar documentos largos, contratos, manuales técnicos.

- o1 / o3: Modelos de razonamiento avanzado. Más lentos y costosos, pero significativamente mejores para problemas que requieren pensar paso a paso: matemáticas, lógica, planificación compleja.

- GPT-4o-mini: Versión más pequeña y económica de GPT-4o. Buen balance para casos donde GPT-4o es excesivo pero necesitas más que el modelo base.

Modelos de Meta (Llama)

- Llama 3.3 70B Instruct: Alto rendimiento, open source, sin costes de licencia del modelo (solo pagas el compute). Excelente para organizaciones que quieren reducir dependencia de OpenAI.

- Llama 3.1 405B: El modelo más grande de Meta. Para tareas que requieren máxima capacidad y donde el coste no es la prioridad.

- Llama 3.2 Vision: Variante multimodal de Llama con capacidades de análisis de imagen.

DeepSeek

- DeepSeek R1: Especializado en razonamiento matemático y lógico. Rendimiento comparable a o1 de OpenAI pero con diferente arquitectura. Muy bueno para agentes que necesitan resolver problemas analíticos.

Otros modelos notables

- Mistral Large: Modelo europeo con buen rendimiento general y menor latencia que GPT-4.

- Cohere Command R+: Optimizado para RAG (Retrieval-Augmented Generation). Ideal si tu agente trabaja mucho con búsqueda en documentos.

- Phi-3: Modelo pequeño de Microsoft, sorprendentemente capaz para su tamaño. Útil para tareas donde la latencia es crítica.

Modelos propios (fine-tuned)

Azure AI Foundry permite subir y desplegar modelos que hayas entrenado con tus propios datos. Esto es especialmente valioso cuando:

- Tu dominio tiene terminología muy específica (legal, médico, industrial)

- Necesitas que el modelo siga un estilo de comunicación particular

- Quieres que el modelo tenga conocimiento específico de tu empresa

Consideraciones de costes

La arquitectura híbrida permite optimizar costes de forma inteligente. Aquí están los factores a considerar:

Modelo base de Copilot Studio

Incluido en la licencia de Copilot Studio. Sin coste adicional por inferencia. Limitado en capacidades pero suficiente para muchos casos.

Modelos de Azure AI Foundry

Pago por uso (tokens consumidos). El precio varía enormemente según el modelo:

- GPT-4o: ~$5 por millón de tokens de entrada, ~$15 por millón de salida

- GPT-4o-mini: ~$0.15 por millón de entrada, ~$0.60 por millón de salida

- Llama 3.3 70B: ~$0.50 por millón de tokens (sin coste de licencia del modelo)

- o1: ~$15 por millón de entrada, ~$60 por millón de salida

Nota: Los precios cambian frecuentemente. Consulta la página oficial de precios de Azure para datos actualizados.

Estrategia de optimización

- Usa el modelo base de Copilot Studio para tareas simples (saludos, FAQs, navegación).

- Escala a modelos medios (GPT-4o-mini, Llama) para consultas que necesitan más capacidad.

- Reserva modelos costosos (GPT-4 Turbo, o1, agentes especializados) para las consultas que realmente los requieren.

- Implementa caché de respuestas para consultas repetitivas.

- Monitoriza el uso desde el Power Platform Admin Center para detectar anomalías.

Gobernanza y seguridad

Las conexiones entre Copilot Studio y Azure AI Foundry no son "todo vale". Hay controles de gobernanza que debes conocer:

Políticas de conectores DLP

Desde el Power Platform Admin Center puedes crear políticas que controlen qué conectores (incluyendo Azure AI Foundry) pueden usarse en cada entorno. Esto permite, por ejemplo, bloquear el uso de modelos externos en el entorno de producción pero permitirlos en desarrollo.

Autenticación con Entra ID

Las conexiones a Azure AI Foundry usan Microsoft Entra ID (antes Azure AD) para autenticación. Esto significa que puedes aplicar políticas de acceso condicional, MFA, y auditoría centralizada.

Auditoría de llamadas

Todas las llamadas a modelos de Foundry quedan registradas tanto en los logs de Copilot Studio como en los de Azure. Útil para cumplimiento normativo y debugging.

Límites de uso

Puedes configurar cuotas de tokens por día/mes tanto en Azure AI Foundry como en Copilot Studio para evitar sorpresas en la facturación.

Redes privadas

Para escenarios de máxima seguridad, Azure AI Foundry soporta despliegue con Private Endpoints, asegurando que el tráfico nunca pasa por Internet público.

Limitaciones actuales (enero 2026)

Aunque la integración es potente, hay algunas limitaciones a tener en cuenta:

- Funcionalidad en preview: Algunas características de integración aún están en preview y pueden cambiar antes de la disponibilidad general.

- Disponibilidad regional: No todos los modelos están disponibles en todas las regiones de Azure. DeepSeek R1, por ejemplo, solo está disponible en East US, West US y South Central US actualmente.

- Latencia adicional: Llamar a un modelo externo añade latencia respecto al modelo integrado de Copilot Studio (típicamente 200-500ms adicionales).

- Depuración más compleja: Los errores que ocurren en el modelo de Foundry pueden ser más difíciles de diagnosticar que los del modelo integrado.

- Límites de contexto: Aunque los modelos grandes soportan contextos extensos, la integración puede tener límites en la cantidad de datos que puedes pasar en una sola llamada.

Conclusión: el futuro es híbrido

La integración entre Copilot Studio y Azure AI Foundry representa un cambio de paradigma en cómo construimos agentes de IA empresariales. Ya no tienes que elegir entre la facilidad del low-code y la potencia de los modelos de vanguardia. Puedes tener ambos, en la misma solución.

Para organizaciones que ya usan Power Platform, esta integración permite una evolución natural: empezar con agentes simples usando las herramientas visuales de Copilot Studio, y escalar gradualmente a arquitecturas más sofisticadas con Azure AI Foundry cuando el caso de uso lo requiera. Sin reescribir nada, sin migrar a otra plataforma.

El mensaje de Microsoft es claro: Copilot Studio para la experiencia de usuario, la orquestación y el desarrollo rápido; Azure AI Foundry para el trabajo pesado, la personalización profunda y el control empresarial. Juntos, forman probablemente la plataforma más completa actualmente disponible para construir agentes de IA a escala.

La pregunta ya no es si deberías usar modelos avanzados en tus agentes. La pregunta es cuándo y cómo empezar.

Recursos y documentación oficial

Aún no hay comentarios. ¡Sé el primero en comentar!